Cada vez las empresas, independientemente del sector al que se dediquen, dependen más del área IT de la compañía. Ya no nos podemos imaginar una empresa de cualquier tipo que no tenga página web o al menos un espacio en Facebook donde publicitar sus servicios. En el caso de empresas que se dediquen a la venta de productos, la parte digital cobra mucho más protagonismo. La mayoría de las pymes ya disponen de página web donde vender sus productos o incluso muchas compañías ya no disponen de tienda física y basan todo su negocio en plataformas on-line.

Debido a la Transformación Digital y el despegue del Internet de las Cosas, la nueva Industria 4.0 ya es una realidad, lo que conlleva que el control de las grandes factorías esté mucho más digitalizado y dependa la producción en gran medida del buen funcionamiento de la plataforma IT de la compañía. Es pues, en los centros de datos, donde se concentran la mayoría de las operaciones y donde recae toda la responsabilidad para que la empresa siga funcionando sin problemas.

En este caso, la gestión de la capacidad del centro de datos es vital para que el negocio siga funcionando. Un fallo en un data center o una incorrecta planificación del crecimiento del mismo por una mala gestión de la capacidad, puede hacer que el negocio se pare o se vea afectada su producción por no poder asignar los recursos IT necesarios que demande la compañía. Es responsabilidad del gestor del centro de datos, que éste sea capaz de adelantarse a las necesidades futuras, y a la vez sea óptimo y no esté sobredimensionado.

Para conseguir esto, sin tener una bola de cristal, se deben seguir una serie de consejos de buenas prácticas que permiten optimizar los recursos disponibles en el centro de datos. Lo fundamental es tener conocimiento de las necesidades y acciones que va a llevar a cabo la empresa a corto y medio plazo, para poder preparar la infraestructura IT para estas nuevas demandas. Parece algo obvio, pero en más de una vez, una gran empresa adquiere otras compañías y quieren consolidar las plataformas en un único centro de datos, y éste no soporta la carga adicional. También a veces ocurre que alguna empresa saca un nuevo producto, que resulta ser un éxito, y los recursos informáticos que el nuevo servicio demanda no pueden ser soportados por la infraestructura actual.

En otras ocasiones, el responsable de la infraestructura IT de una compañía, CIO o CTO, tiene muy claras cuáles son sus necesidades a corto y medio plazo para poder desplegar todos los servicios que demandará su empresa en un futuro. Pero quizás, en su hoja de ruta marcada, se encuentre en un futuro que el centro de datos donde necesite montar, por ejemplo, la nueva plataforma de virtualización de alta densidad, no soporte a nivel de UPS o de climatización la demanda exigida. En muchos centros de datos, la infraestructura mecánica del data center es responsabilidad del departamento de servicios generales, la mayoría de las veces externalizado, y éste no tiene visibilidad de los nuevos proyectos de la compañía. La comunicación por lo tanto, entre el mundo facilities y el mundo IT, debe ser también fundamental.

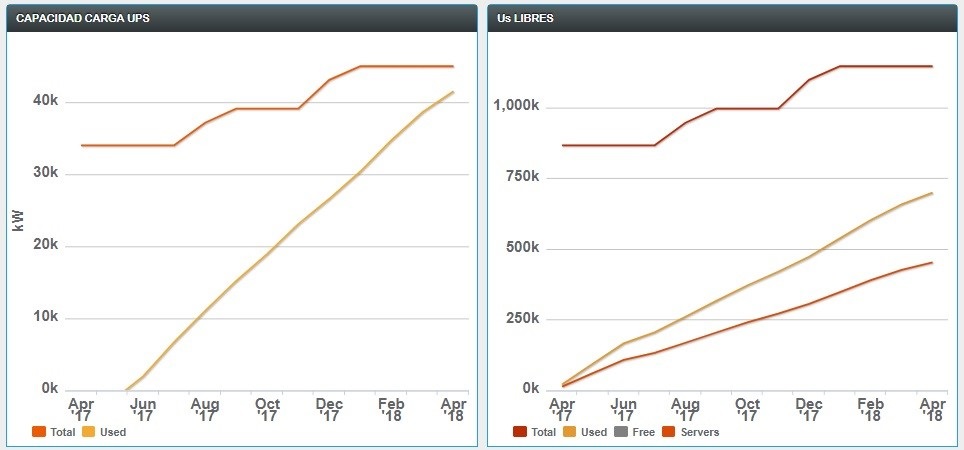

Para la gestión de la capacidad, es necesario disponer de las herramientas necesarias para poderse adelantar a los picos de carga, que puedan poder poner en riesgo nuestra infraestructura. Un buen ejemplo sería un sistema DCIM (Data Center Infraestructure Management), que monitorizará la carga CPU de cada equipo IT y también la demanda energética por rack además de la capacidad restante en la instalación en tiempo real. Por otro lado, definiendo unos buenos cuadros de mando (dashboards), donde se pueda ver la tendencia de nuestra instalación y también el histórico de años anteriores, podemos planificar de forma muy eficiente las necesidades a futuro de nuestro centro de datos. Adicionalmente, ajustando los niveles de advertencia de estos cuadros de mando, podemos adelantarnos a los requisitos de nuestra instalación para un plazo más largo de tiempo.

Gracias a los cuadros de mando, podemos ver el histórico y la tendencia de nuestra instalación. Es muy común que los picos cargas de trabajo se repitan periódicamente debido a trabajos recurrentes en las empresas, como pueden ser cierres contables (trimestrales, anuales…), campañas especiales (Navidad, verano…). Para estos picos de trabajo una solución interesante es la externalización de servicios no críticos en plataformas cloud públicas y dejar los recursos propios para dar servicio a esta demanda excepcional.

No sólo en momentos de picos de carga de trabajo es interesante la externalización de los servicios menos críticos. Haciendo uso de empresas de cloud pública en modo pago por uso, los entornos de desarrollo y otras aplicaciones menos importantes pueden ser externalizadas, permitiéndonos un ahorro de espacio físico, consumo eléctrico, climatización e incluso licencias propias de virtualización. Todo este ahorro, nos puede proporcionar un tiempo adicional de margen de crecimiento, si la capacidad de nuestro centro de datos se viera comprometida a corto plazo.

En el caso de que no se opte por una externalización de los servicios menos críticos, es también aconsejable valorar si estos requieren un nivel de redundancia igual que las plataformas más importantes. En muchos casos la gran mayoría del centro de datos se encuentra virtualizado en plataformas de alta disponibilidad. El propio hipervisor proporciona redundancia en el caso de que algún servidor físico tenga algún problema, moviendo automáticamente las máquinas virtuales a otro host que puede estar en otra parte del centro de datos o incluso en otro edificio. Por lo tanto es aconsejable valorar si realmente es necesaria una redundancia 2N+1, o incluso 2N para estos tipos de entornos. Quizás sería aconsejable la migración a una redundancia N, y la capacidad ganada administrarla para un futuro crecimiento del centro de datos.

Una vez detectados los crecimientos a futuro de nuestra infraestructura IT, es necesario conocer cómo se va a comportar nuestro centro de datos ante esta nueva demanda de recursos. Un buen sistema DCIM cuenta con simuladores de escenarios “what if”, en el cual se puede representar cómo reaccionará el data center en términos de energía y climatización. Incluyendo una simulación CFD (Dínamica de Fluidos Computacional) podremos simular en tres dimensiones el comportamiento de la temperatura de nuestro centro de datos según las nuevas cargas añadidas y la detección de posibles puntos de calor generados por los nuevos equipos instalados.

Si además la plataforma de gestión DCIM dispone de simulación de impacto en la infraestructura, podemos usarla para ver qué equipos se ven afectados, por ejemplo ante un parón de una UPS, y ver qué carga de compensación asume la otra rama de la UPS y todas las protecciones eléctricas desde esta UPS redundante hasta el equipo final en el rack. Esta simulación de impacto, también nos puede ayudar para diseñar un nuevo modelo de redundancia, dotando de menos necesidades a racks donde se incluyan equipos de desarrollo o con alta disponibilidad a nivel de virtualización, centrando los recursos en los elementos más críticos del centro de datos como pueden ser las zonas de comunicaciones o de almacenamiento.

En resumen, para poder tener una buena gestión de la capacidad es fundamental que exista una buena comunicación entre los diferentes departamentos involucrados: gestores del negocio, responsables IT y administradores del centro de datos. Con esto podremos adelantarnos a las necesidades de la empresa. La virtualización puede ser una gran aliada para gestionar la capacidad y ajustar la redundancia física según la criticidad del servicio. Importante detectar los picos de carga de nuestra instalación y no gestionarla a través de la medida del consumo de energía, ya que puede haber procesos puntuales que supongan un consumo alto puntual que pueda hacer que nuestra infraestructura se venga abajo.

Todo esto, apoyado en un buen sistema de gestión que nos ayude a visualizar todos los parámetros necesarios, nos permitirá administrar de manera eficiente la capacidad de nuestro centro de datos.